結論は?

紅謡 Mistral専門官

紅謡 Mistral専門官お先に結論を言います。

・Mistral AI SASが開発した大規模言語モデル。

・Mistral AI SASは、設立からまだ2年ほどの若い企業です。

・Mistralは返事が早いLLM。

・Mistralは無料で使えて、商用利用もOK。

つまり?

最速クラスの応答と無料で商用利用OKを兼ね備えたLLMです。

はじめに

2023年に登場したMistral AI SASが開発したモデルが、急速に存在感を高めています。

特に、オープンソースでありながら高性能・高効率を実現している点が評価され、MetaのLLaMAシリーズやOpenAIのGPTシリーズに対抗する存在として注目されています。

この記事では、Mistralの技術的な特徴から、代表的なモデル、他のLLMとの比較、そして今後の展望までを網羅的に解説するぜ。

Mistralの特徴と技術的背景

Mistralのモデルは、Transformerアーキテクチャをベースにしており、特にデコーダ専用の構成を採用しているのが特徴です。これは、自然言語生成に特化した設計で、推論速度と精度のバランスを最適化するための工夫といえます。

わかりやすく言うと、

Transformerという大規模言語モデルをベースに、入力を読んで、次に来る言葉を予測する(デコーダ専用)の構成を導入したことで、質問してから1秒でスパッと返ってくるようになったわけです。

しかも、モデル自体が軽量なので、低スペックのPCでも動かせる手軽さも魅力です。

また、Mistralは「Mixture of Experts(MoE)」という技術も積極的に取り入れています。

MoEとは、複数の専門家モデルの中から、そのとき必要な一部だけを選んで動かす仕組みです。これにより、計算資源を節約しながらも高い性能を発揮できるのが特徴です。

たとえば、「DXの専門家Mistral」や「コード生成の専門家Mistral」など、得意分野の異なるMistralたちがチームを組んで、必要なときだけ出番が回ってくるイメージです。

全員が一斉に働くわけじゃないから、軽量で効率的なモデル構成が実現できます。

トレーニングに使われたデータの詳細は公開されていないけれど、多言語かつ多様なデータセットを用いているとされており、英語以外の言語にもある程度対応できる柔軟性を持っています。

Mistralの主なモデルとその特徴

現在、Mistral AIが公開している代表的なモデルには、「Mistral 7B」と「Mixtral 8x7B」があります。

「Mistral 7B」は、約70億パラメータを持つ軽量なモデルで、デコーダ専用の構成を採用している。高い精度と高速な推論性能を両立しており、リソースの限られた環境でも扱いやすいのが魅力だ。しかも、Apache 2.0ライセンスで提供されているため、商用利用にも制限がない。

一方、「Mixtral 8x7B」は、8つの7Bモデルを組み合わせたMoE構成のモデル。実行時にはそのうち2つの専門家が選ばれて動作するため、実質的には14B相当の性能を持ちながら、計算コストは抑えられている。こちらもApache 2.0ライセンスで、商用利用が可能です。

活用事例とユースケース

Mistralのモデルは、その軽量性と性能のバランスから、さまざまな分野での活用が期待されている。

たとえば、チャットボットやバーチャルアシスタントでは、自然な対話生成と高速な応答が求められるが、Mistral 7Bはそのニーズにしっかり応えてくれます。

また、コード生成や補完といった開発支援ツールにも活用されており、PythonやJavaScriptなどの言語での精度も高い。

さらに、翻訳や要約といった自然言語処理タスクにも対応でき、多言語対応のアプリケーション開発にも向いています。オンプレミスでの運用も可能なため、セキュリティ要件の厳しい企業でも導入しやすいのが強みです。

他のLLMとの比較

Mistralは、MetaのLLaMA 2やOpenAIのGPT-3.5、GPT-4といった他の大規模言語モデルと比較しても、かなり競争力がある。

たとえば、Mistral 7Bは、同じレベルのLLaMA 2 7Bよりも多くのベンチマークで優れたスコアを記録しており、特に推論速度やメモリ効率の面で優れている。

また、Mixtral 8x7Bは、GPT-3.5クラスの性能を持ちながら、オープンソースであるという点で大きな有利がある。

ライセンス面でも、MistralはApache 2.0を採用しており、商用利用に制限がない。一方、MetaのLLaMAシリーズは商用利用に制限があるため、企業導入を検討する際にはMistralの方が柔軟性が高いといえます。

今後の展望とまとめ

Mistralは、オープンソースLLMの中でも特に注目される存在です。

今後はさらに大規模なモデルや、より効率的なMoE構成の進化が期待されており、AI開発の民主化を後押しする存在として注目されている。

欧州発のAI企業として、倫理的な配慮や透明性にも力を入れている点も、他の大手企業とは一線を画すポイントです。

まとめると、Mistralはスタートアップや研究者にとってはもちろん、商用利用を検討する企業にとっても非常に魅力的な選択肢です。軽量で高性能、しかもオープンソースという三拍子そろったこのモデルは、今後のLLMの標準になる可能性があります。

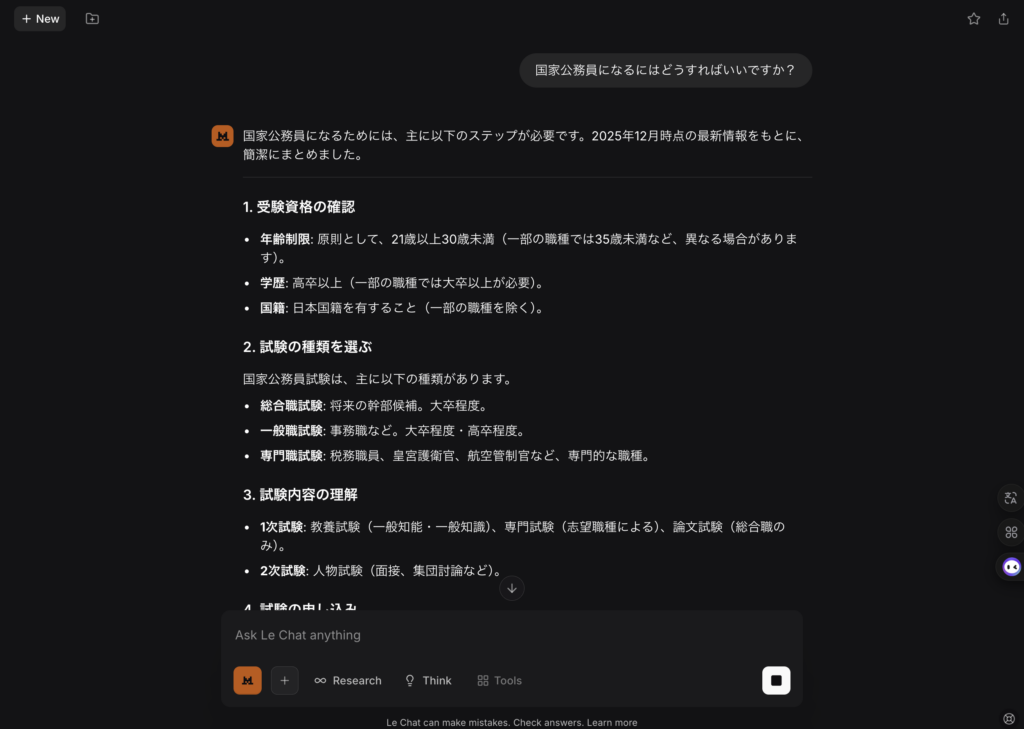

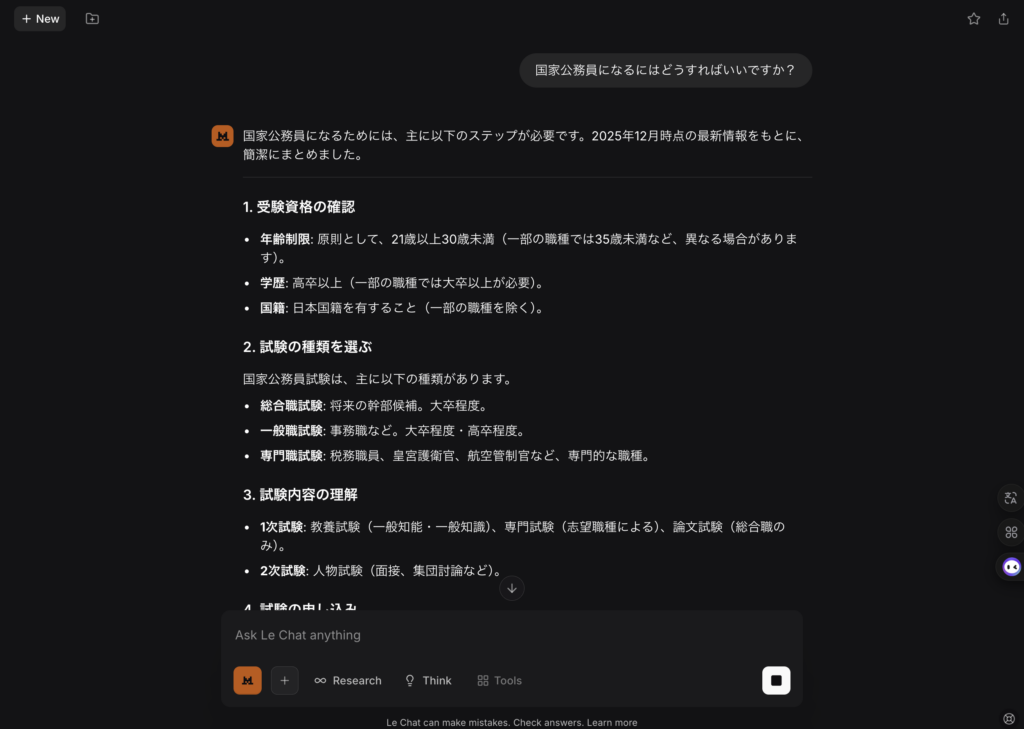

おまけですが、Mistralを実際に使ってみました。

まず感じたのは、UI/UXデザインはシンプルさで動作の軽さ。起動が早くてストレスが感じませんでした。

試しに、国家公務員はどうやってなれますかって聞いてみると…

そして何より驚いたのが、返答の速さ。質問してから文章が表示されるまでが本当に早くて、「これが軽量モデルの強みか」と実感しました。

返ってきた答えはシンプルで現実的でした。

「今すぐは難しいかもしれないけれど、チャンスを見つけて動ける人が向いている」といった、リアルタイム感のある回答が印象的でした。

全体として、シンプルさとスピードを重視したLLMという印象で、使っていてとても面白かったです。

今後の進化にも大いに期待できるモデルだと感じてます。

コメント