結論は?

昴惟 Pythia専門官

昴惟 Pythia専門官・EleutherAIが開発した大規模言語モデル!

・研究向けのLLM!

・AIが賢くなる「成長の全記録(チェックポイント)」を全部公開してる変態的モデル!

・でも、調整なしで話しかけると、ヤバい言葉が返ってくるかもよ…

つまり?

便利に使いたいなら他を当たれ。

でも、AIの中身を解剖したいなら…… Pythiaを使って、お前もLLM研究者にならないか?

はじめに

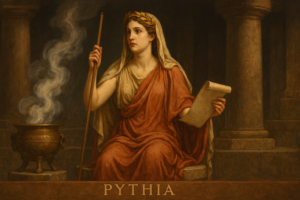

おい、Pythiaって聞いたことある? いや、ギリシャ神話の神託の巫女じゃなくてさ、EleutherAIが開発した大規模言語モデル(LLM)のスイートのことだよ。

2023年にリリースされて、AI研究者たちの間で「これ神すぎる!」って大騒ぎになったやつ。なんでかって? 普通のLLMみたいに「俺が一番賢いぜ!」って性能自慢するんじゃなくて、純粋に研究のために生まれたから。ふざけんなよ、OpenAIのモデルみたいにブラックボックスじゃなく、全部オープンでトレーニング過程まで丸裸にしてくれるんだぜ。

Pythiaの基本スペック:16個のモデルが勢揃い

Pythiaは16個のモデルからなるスイートで、パラメータ数は70M(7000万)から12B(120億)まで8種類。

で、それぞれに2つのバリエーションがあるんだ。

- 標準版(Pileで訓練):The Pileっていう825GBの巨大英語データセットで訓練。

- Deduped版(重複除去版):同じPileだけど、重複データをグローバルに削除したバージョン(207Bトークンくらい)。重複なしでクリーンだから、メモリゼーション(丸暗記)の研究に便利。

全モデルが同じデータ順序で訓練されてるのがミソ。全部で約300Bトークン見て、ほぼ1エポック(標準版)か1.5エポック(Deduped版)。これでスケーリング(サイズが変わるとどうなるか)を公平に比較できるんだよ。おい、普通のモデルみたいに「俺のデータは秘密!」って隠さないのが偉いよな。

モデルサイズ一覧(おおよそのパラメータ数)

- 70M

- 160M

- 410M

- 1B(10億)

- 1.4B

- 2.8B

- 6.9B

- 12B

各サイズで標準とDedupedがあるから合計16個。

Hugging Faceで全部無料ダウンロード可能!

なんでPythiaが革命的なのか? 研究者の夢みたいな設計

普通のLLM(GPTとかLLaMAとか)は性能重視で、中間チェックポイントなんてほとんど公開しないだろ?

Pythiaは各モデルに154個の中間チェックポイントを公開! ステップ0から143000まで、ログスケールで細かく保存されてる。これで「トレーニング中にモデルがどう賢くなっていくか」を精密に分析できるんだ。

主な研究貢献

- メモリゼーションの研究:モデルがデータを丸暗記するタイミングやパターンを解明。

- スケーリングローの検証:サイズが大きくなると性能がどう変わるか。

- バイアス低減:ジェンダーバイアスとかをデータ頻度でコントロール。

- Few-shot学習:用語の頻度が少数ショット性能にどう影響するか。

論文(arXiv:2304.01373)では、PythiaがOPTやGPT-Neoと同じサイズで同等かそれ以上の性能出してるって報告されてるのに、性能じゃなくて解釈可能性(interpretability)を優先してるのが笑える。ふざけてるよな、でもそれが本気で科学を進めてるんだぜ。

Pythiaの使い方:Hugging Faceで簡単ダウンロード

全部Hugging Faceにホスティングされてるよ。たとえば

- EleutherAI/pythia-12b

- EleutherAI/pythia-70m-deduped

Transformersライブラリでロード可能。チェックポイント指定で中間状態も使えるんだ。研究したいヤツはGitHubのEleutherAI/pythiaリポ見てくれ。データローダー再現ツールも付いてるぜ。

注意点

英語オンリーで、バイアスや有害出力あり。商用じゃなく研究用だから、人間レビュー必須だってさ。ふざけんな、賢いけど危ないおもちゃだよ。

RLHF(人間による行儀作法のしつけ)を受けてないから、平気で性的な描写や暴力的な言葉を吐き出すよ…フィルター無しのネットの闇をそのまま学習してるからな…扱いにはほんとに気をつけて!

まとめ:PythiaはAI研究の新定番、君も遊んでみ?

Pythiaは「LLMのブラックボックスをぶち壊す」ためのツール。

EleutherAIのオープンソース精神が詰まった神スイートだよ。興味湧いたらHugging Face行ってダウンロードしてみ。トレーニングダイナミクス分析したら、君も論文書けるかもよ?

コメント